Sokan tapasztalták már, hogy amikor új videokártyát szeretnének vásárolni, a bőség zavara uralja a boltok és webáruházak polcait. Melyik GPU a legjobb választás? Vajon az azonos kártya lesz tökéletes mind a legújabb játékokhoz, mind a gépi tanulásban használt modellekhez? Ezek a kérdések nemcsak laikusokat, hanem haladó felhasználókat és fejlesztőket is foglalkoztatnak. A grafikus processzorok teljesítménye és felhasználási területei igencsak eltérőek lehetnek: amíg egy gamer a maximális FPS-t keresi, addig a data scientist vagy a mesterséges intelligencia fejlesztő egészen más szempontokat helyezhet előtérbe.

Minden GPU-nak megvan a maga erőssége, de fontos tudni, melyik területre optimalizálták őket. A játékhoz tervezett modellek általában a lehető legjobb grafikai élményt és sebességet kínálják, míg a gépi tanuláshoz fejlesztett változatoknál a multitasking, memóriakezelés és a számítási teljesítmény kerül előtérbe. Ezért a megalapozott döntéshez érdemes megvizsgálni a legfontosabb különbségeket – nem csak ár, hanem technológiai oldalról is.

Az alábbiakban részletesen átnézzük, hogy melyik GPU miben erős, milyen tulajdonságokra érdemes figyelni játékosként vagy gépi tanulási projektekhez, és hogyan hasonlíthatók össze a vezető modellek. Ezzel a tudással magabiztos döntést lehet hozni a következő beszerzésnél.

Alapvető különbségek a játékra és gépi tanulásra optimalizált GPU-k között

A játékosok számára tervezett GPU-k – mint az NVIDIA GeForce vagy az AMD Radeon szériák – elsődlegesen a valós idejű grafikus renderelést helyezik előtérbe. Ezeknél jellemző a magas órajel, fejlett anti-aliasing technikák, illetve a gyors textúra feldolgozás. A cél, hogy a legmodernebb játékokban is zökkenőmentes, nagy felbontású, és magas képfrissítési sebességű élményt kapjon a felhasználó.

Gépi tanulásra, például deep learninghez, leginkább az NVIDIA RTX vagy Quadro, illetve az AMD Instinct sorozatokat alkalmazzák. Ezeket a modelleket jellemzően nagyobb VRAM-mal szerelik, támogatják a speciális számítási (például tensor core) utasításokat, és optimalizáltak a párhuzamos adatfeldolgozásra, ami elengedhetetlen a neurális hálózatok tanításánál.

A fő különbségek tehát a célzott felhasználásban, a hardveres képességek hangsúlyában és a támogatott szoftveres ökoszisztémában jelentkeznek. Az alábbi táblázat jól szemlélteti a legfontosabb paramétereket:

| Játékhoz ajánlott GPU | Gépi tanuláshoz ajánlott GPU |

|---|---|

| Magas órajel, gyors memória | Nagy VRAM, magas számítási teljesítmény |

| Kiemelkedő valós idejű grafika | CUDA, Tensor, ROCm támogatás |

| Főként DirectX/DirectML optimalizáció | Legújabb AI könyvtárak támogatása |

| Kedvezőbb ár-érték arány játékra | Hosszabb élettartam, stabilitás |

Mire figyeljünk, ha játékhoz választunk GPU-t?

A gamer GPU-kat egyrészt a lehető legjobb vizuális élményre, másrészt az alacsony késleltetésre tervezik. Így a választás során az alábbi tényezőkre érdemes figyelni:

🎮 Grafikus teljesítmény valós idejű játékokban

⭐ Ray tracing és upscaling technológiák támogatása

⚡ Ventilátor- és hűtési megoldások minősége

A modernebb kártyák, például az NVIDIA RTX 4000 sorozat vagy az AMD RX 7000-es modellek mind támogatják a valós idejű ray tracing-et, ami jelentősen feldobja a fények, tükröződések és árnyékok minőségét a játékokban. Emellett az olyan szoftveres frissítések, mint a DLSS vagy FSR, lehetővé teszik a magasabb felbontás és gyorsabb teljesítmény egyidejű elérését.

A hűtés is kritikus tényező, különösen a hosszabb játékmenetek során. Egy jól szellőző ház és hatékony ventilátor rendszer – akár dupla vagy tripla ventilátoros kialakítással – növeli az alkatrészek élettartamát és stabilitását.

A gépi tanulási projektekhez szükséges GPU-jellemzők

A mesterséges intelligencia és gépi tanulási területen dolgozók számára a GPU-k kiválasztásánál egészen más szempontok a mérvadók, mint egy gamer számára. Az AI modellek nagy mennyiségű adatot, több milliárd számítási lépést igényelnek, gyakran heteken át futó tréningekkel.

A legfontosabb paraméterek:

🧠 VRAM mérete: Minél nagyobb, annál bonyolultabb modelleket lehet tanítani egyszerre

💡 CUDA, ROCm, OpenCL támogatás: Különösen deep learning könyvtárak (TensorFlow, PyTorch) esetén kulcsfontosságú

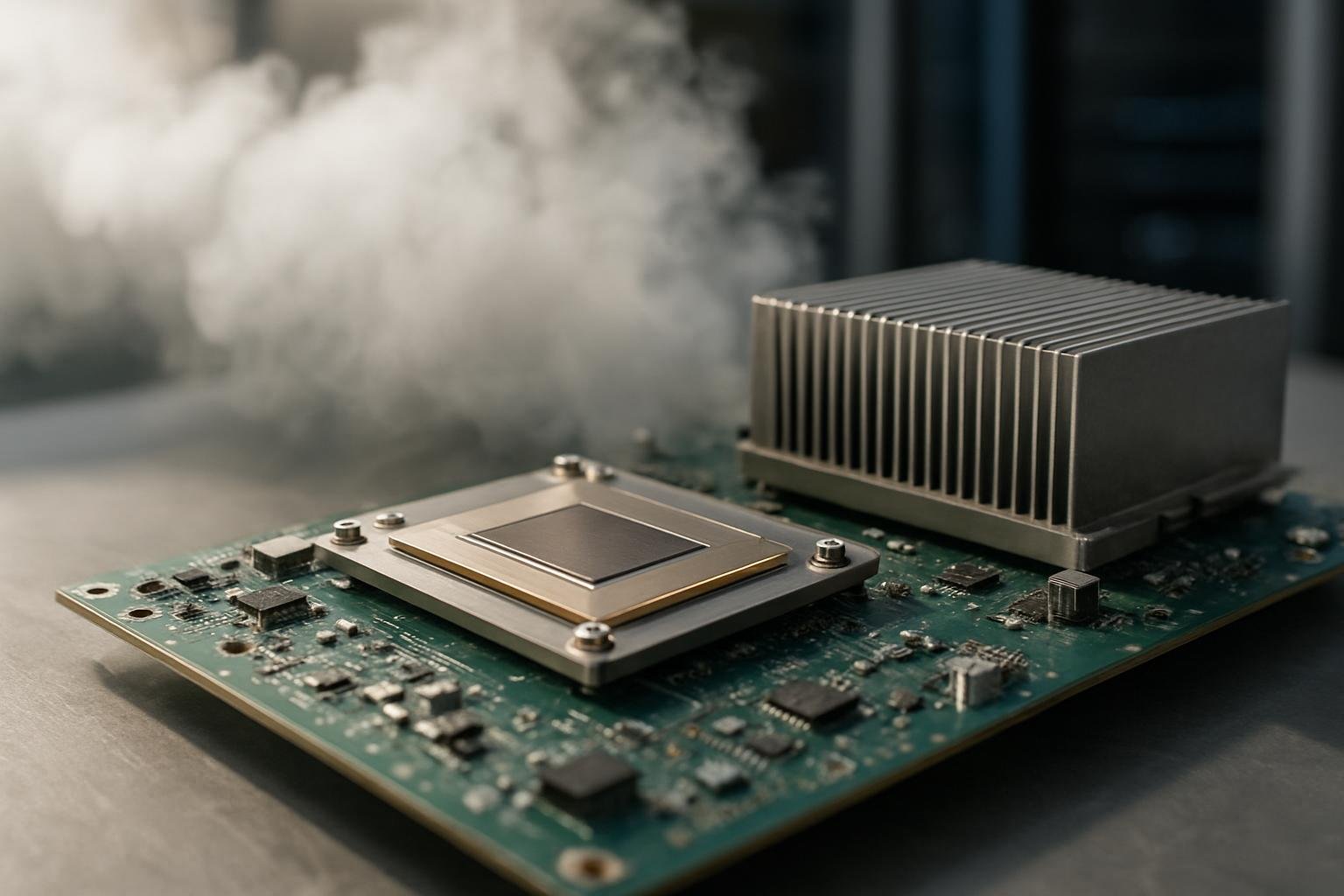

🔬 Tensor Core és FP16/FP32 teljesítmény: Ezek gyorsítják a tanítási folyamatokat

A nagy VRAM (legalább 12-24 GB) lehetővé teszi a nagyobb batch méretű, komplexebb modellek használatát. Az NVIDIA modellek esetén a CUDA támogatás szinte kötelező, hiszen számos gépi tanulási könyvtár kizárólag ezt támogatja hatékonyan. A tensor core-ok és az alacsonyabb pontosságú műveleti sebesség (FP16, INT8) pedig akár tízszeres gyorsulást eredményez, ezzel lerövidítve a fejlesztési ciklust.

Az alábbi táblázatban néhány népszerű GPU összehasonlítása látható AI szempontból:

| GPU Modell | VRAM | CUDA Magok | Tensor Magok | FP16 Teljesítmény (TFLOPS) |

|---|---|---|---|---|

| RTX 4090 | 24GB | 16384 | 512 | 330 |

| RTX 4070 Ti | 12GB | 7680 | 240 | 135 |

| AMD Instinct MI210 | 64GB | 6656 | Nincs | 181 |

Ár-érték arány és jövőbiztosság – hogyan mérlegeljünk?

A vásárlási döntés során nemcsak a nyers teljesítményt, hanem a hosszabb távú használhatóságot és az esetleges bővítési lehetőségeket is figyelembe kell venni. Egy GPU ára jelentős befektetés, így nem mindegy, milyen kompromisszumokat vállalunk.

🔗 Támogatott szabványok és driver stabilitás

📈 Jövőbeli fejlesztések (pl. új deep learning könyvtárak, játék engine-k) támogatása

⚠️ Energiahatékonyság és melegedés

A gaming kártyák ára tipikusan gyorsabban avul, hiszen a játékok grafikai igénye évről évre nő. Aki nem csak játszani, hanem időnként gépi tanulást is futtatna, annak érdemes lehet olyan hibrid modellt választani, amely mindkét világ előnyeit ötvözi. Az RTX 30xx és 40xx sorozatok például már lehetővé teszik, hogy a játék és a kutatás közötti átjárás kompromisszumok nélkül megvalósuljon.

Az energiahatékonyság szintén egyre fontosabb, főként hosszabb tanítási folyamatok vagy 24/7 üzem esetén. Az újabb GPU-k egyre jobb hatásfokkal dolgoznak, így nemcsak a villanyszámla csökken, de a termikus terhelés is mérséklődik, növelve az eszköz élettartamát.